最近看到高端SEO社群里有同学讨论Robots相关问题,我们从实战的角度,给大家讲讲怎么写Robots写法,以及在实战中可能遇到的问题,都给大家讲一下!希望可以帮助更多不懂的同学!

Robots定义

什么是Robots,简单来讲,其实Robots就是放在网站根目录下的一个TXT文件,但是这个TXT文件对搜索引擎规定,哪些页面可以访问,哪些页面不行。

Robots一般放在网站根目录下,文件名固定为robots.txt的(全部小写)、当搜索引擎要爬取我们网站的时候,会先读一下robots.txt里面的内容,判断哪些URL可以访问,哪些不行,然后进行爬取、收录。

Robots规则

常用的几类语法:

User-agent: 定义搜索引擎的类型

google蜘蛛:googlebot

百度蜘蛛:baiduspider

yahoo蜘蛛:slurp

alexa蜘蛛:ia_archiver

msn蜘蛛:msnbot

Disallow: 定义禁止搜索引擎收录的地址

举个例子来讲:User-agent: * Disallow: /

禁止所有搜索引擎访问网站,(*)为通配符

Allow: 定义允许搜索引擎收录的地址

User-agent: * Disallow: /a/ Allow: /a/b

如上面例子,限制搜索引擎抓取a目录,但允许搜索引擎抓取a目录下的b目录

$通配符

User-agent: * Allow: .htm$

匹配URL结尾的字符。如下面代码将允许蜘蛛访问以.htm为后缀的URL:

*通配符

User-agent: * Disallow: /*.htm

告诉蜘蛛匹配任意一段字符。如下面一段代码将禁止所有蜘蛛抓取所有htm文件:

Sitemaps位置

Sitemap: http://www.xxx.com/sitemap.xml

Robots心得

1、许多朋友都喜欢让搜索引擎不抓取自己的后台,于是将自己的后台地址写到robots.txt里面,其实个人不建议这样做,因为考虑到网络安全,许多Hack都喜欢通过robots.txt看大家的后台,方便攻击!

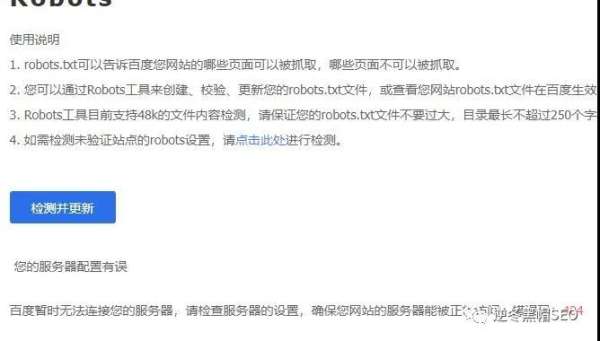

2、网站必须要有robots.txt,如果网站没有robots.txt,搜索引擎随意抓取的话,可能会抓取到一些低质量页面,从而导致网站收录、流量受到影响,如上图是没有robots.txt。

3、当我们做完robots.txt后,一定要去【百度站长工具平台】抓取、测试robots.txt,以及测试URL是否可以抓取。

文章来源:逆冬黑帽SEO(ID:gh_c3dd79adc24e),原文链接:https://mp.weixin.qq.com/s/jjUveBOtsRGaFzgMiq2UrQ

关于西部数码

成都西维数码科技有限公司成立于2002年,注册资本1000万元,总部坐落于“天府之国”——成都,旗下品牌西部数码 (www.west.cn) ,深耕IDC行业十多年,已拥有北京、广东、郑州、成都、绵阳、香港等中国多个云计算IDC安全数据中心和美国等海外数据中心。我们先后自主研发的虚拟主机、弹性云服务器、西数企业云邮箱等产品都广受用户欢迎。我们始终坚持用户体验至上的价值导向,深入挖掘用户需求,目前,有超过一百万用户通过我们注册并管理了超过一千万个域名,累计有超过50万网站在我们的自主研发的云主机平台上运行,服务的用户有:宝贝回家寻子网、四川大学、链家网(北京)科技有限公司、四川省互联网协会、沱牌集团、谭木匠、中铁二局、四川省中国青年旅行社、富森美家居网上商城等

我们始终坚持“以人为本,客户为尊,永续创新”的核心价值观,抢抓各种发展机遇,不断创新发展理念,不断转变发展方式,不断破解发展难题,随着企业的发展,我们经营的业务也不断发展为以云计算为基础的云主机业务、域名注册、域名交易等其他相关业务,公司从最初只有几个员工发展到如今拥有近二百人的精英团队,并在中国IDC、云计算行业中占有一席之地,位列国内三强。成为拥有多项自主知识产权的国家高新技术企业,ICANN和CNNIC双认证的国际顶级域名注册服务机构,首批获得国家工信部颁发的全国云服务牌照企业之一。